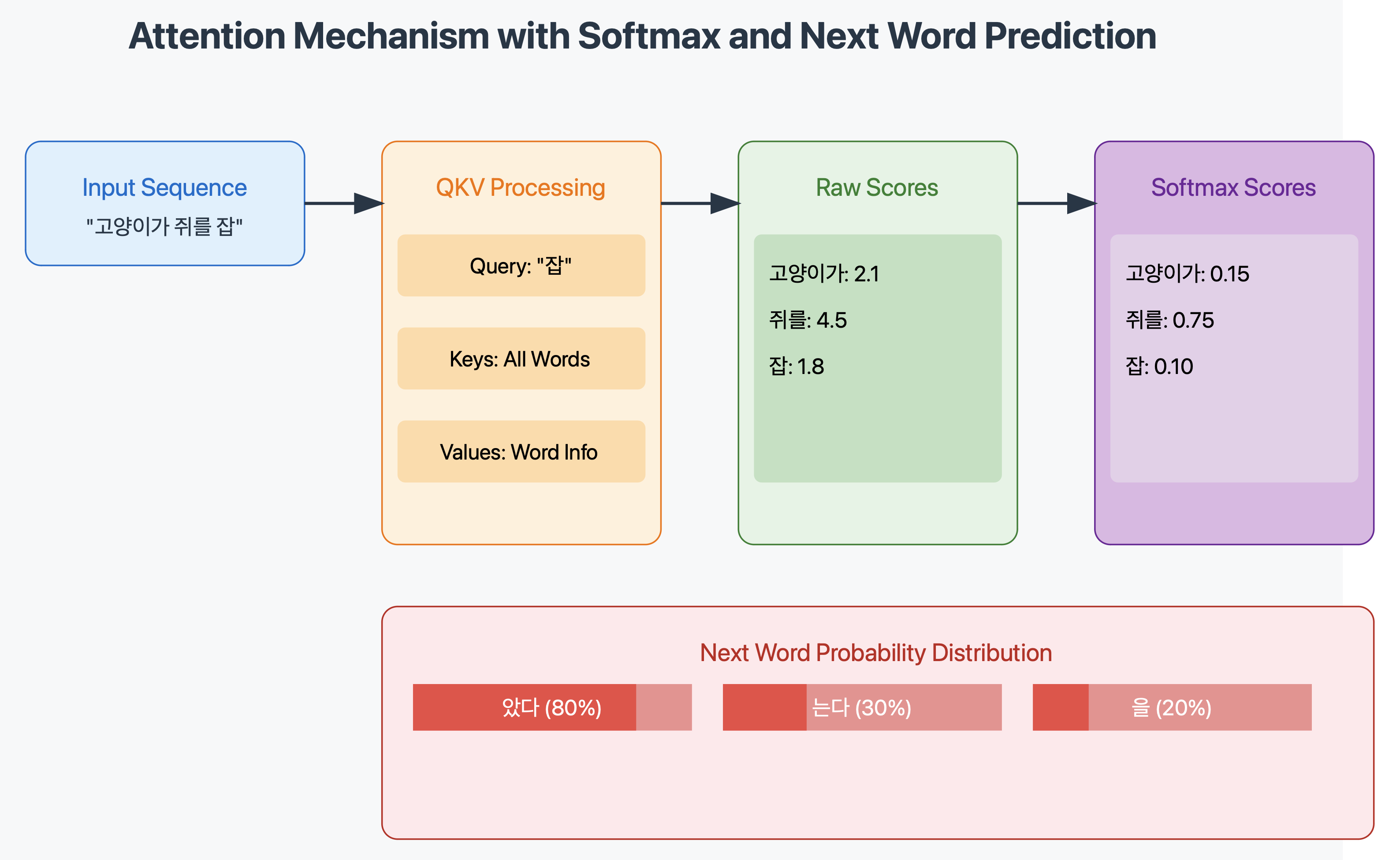

Attention 알고리즘을 단계별로 쉽게 개념적으로 알아보겠습니다:기본 개념Attention은 입력 시퀀스의 각 요소들 간의 관련성을 계산하는 메커니즘입니다"모든 입력을 고려하되, 중요한 것에 더 주목한다"는 개념입니다주요 구성 요소Query (Q): 현재 처리 중인 위치의 벡터Key (K): 다른 위치들의 벡터Value (V): 실제 정보를 담고 있는 벡터작동 과정 a. 각 입력 단어를 벡터로 변환 b. Query와 Key 사이의 유사도 점수 계산 c. Softmax 함수로 점수를 확률로 변환 d. 확률을 Value에 곱하여 가중치 적용 e. 가중치가 적용된 Value들을 합산수식으로 표현 Attention(Q, K, V) = softmax(QK^T/√d_k)Vd_k: 스케일링 팩터(Key의 차원)√..