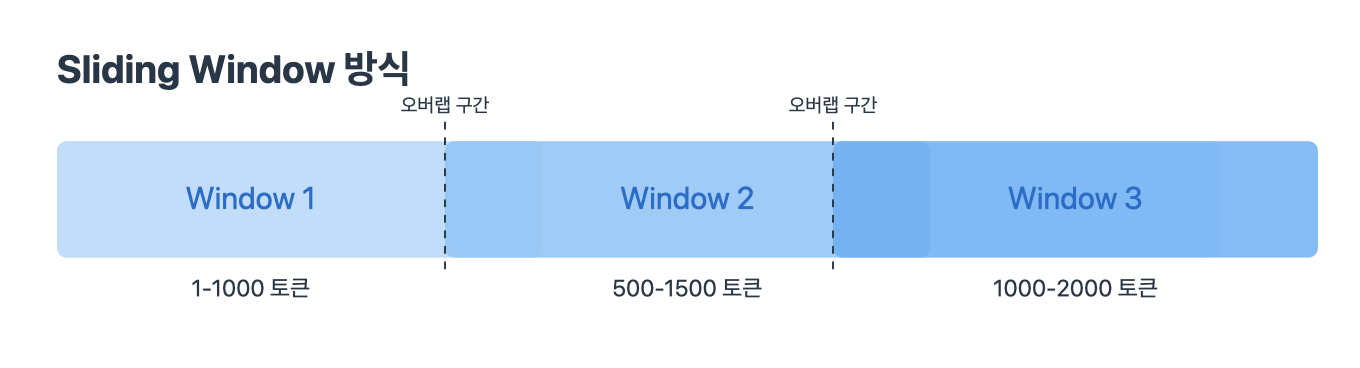

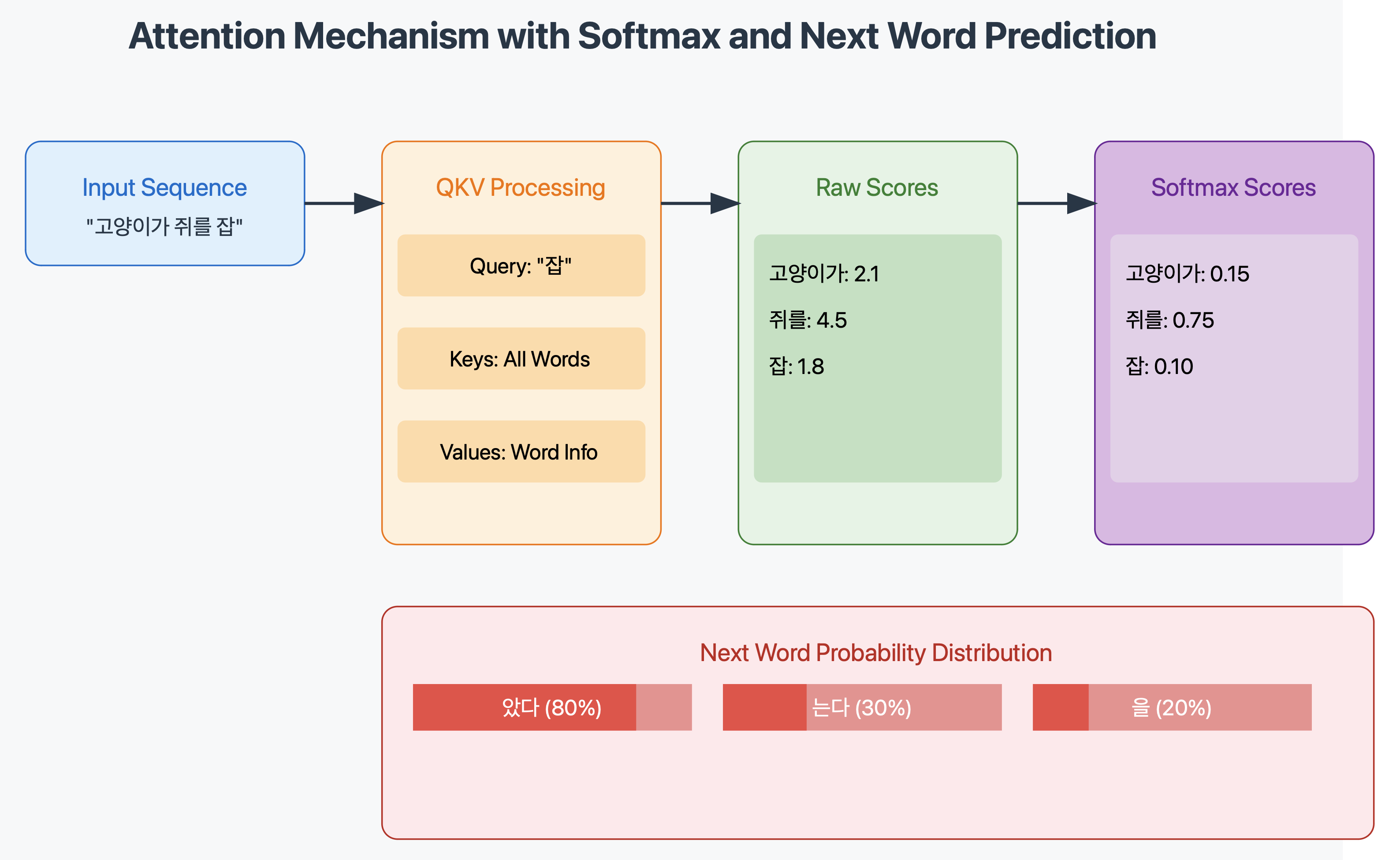

안녕하세요, 이번 시리즈의 글들은 LLM의 동작들에 대해 궁금한 점들을 LLM들과 문답으로 풀어가는 과정을 기록하고자 합니다. 비록 완전히 정확하지는 않겠지만 일반인들이 이해하는 수준에서는 도움이 되지 않을까 생각합니다. 되도록 hallucination이 발생하지 않도록 주의를 기울여 작성해보겠습니다. transformer가 무엇인지 궁금해서 알아보던 과정에 아래와 같은 궁금한 점이 생겼습니다. 최신 초대형 언어 모델인 Claude 3.5 Sonnet은 어떻게 200,000 토큰이라는 방대한 컨텍스트 윈도우를 효율적으로 처리할 수 있을까? 특히 기존 Transformer 아키텍처의 제한사항을 어떻게 극복하였나? 또한 추가적으로 이어서 생기는 저의 궁금함들은 다음과 같습니다. 계산 효율성"200K ×..